Содержание

ГРЭС и ГЭС — что это, как расшифровывается и их отличия

2 675

31 август 2020, Понедельник

Содержание

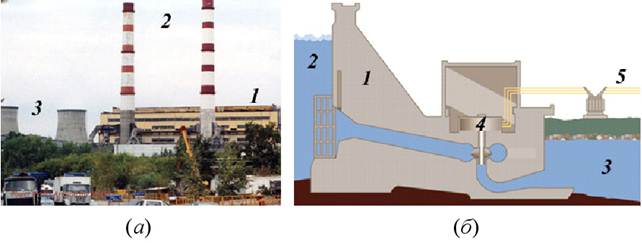

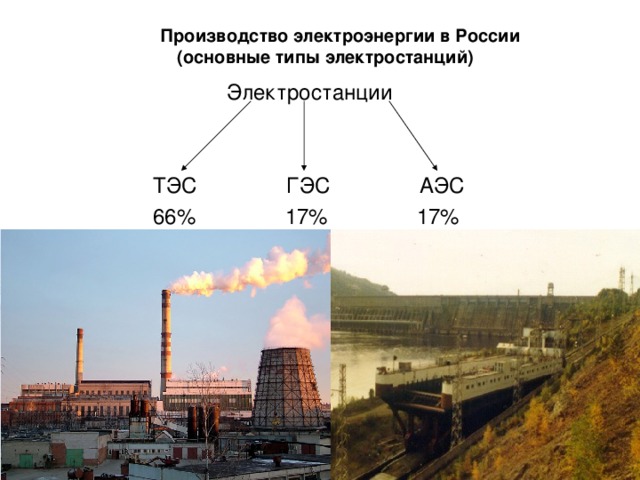

Электрические станции призваны вырабатывать электрическую энергию, однако за счет большого количества подвидов электростанций многие путают назначение каждой из них. Примерно так же случилось в свое время и с ГРЭС и ГЭС. Несмотря на почти одинаковое название, разница в этих станциях колоссальна. Разберемся же, в чем отличие ГЭС и ГРЭС.

Большая путаница между этими двумя станциями по выработке электроэнергии произошла по причине того, что в названиях этих двух станций имеются общие буквы. Однако эти два вида ЭС совершенно различны по своей природе и используют разные источники для выработки электрической энергии.

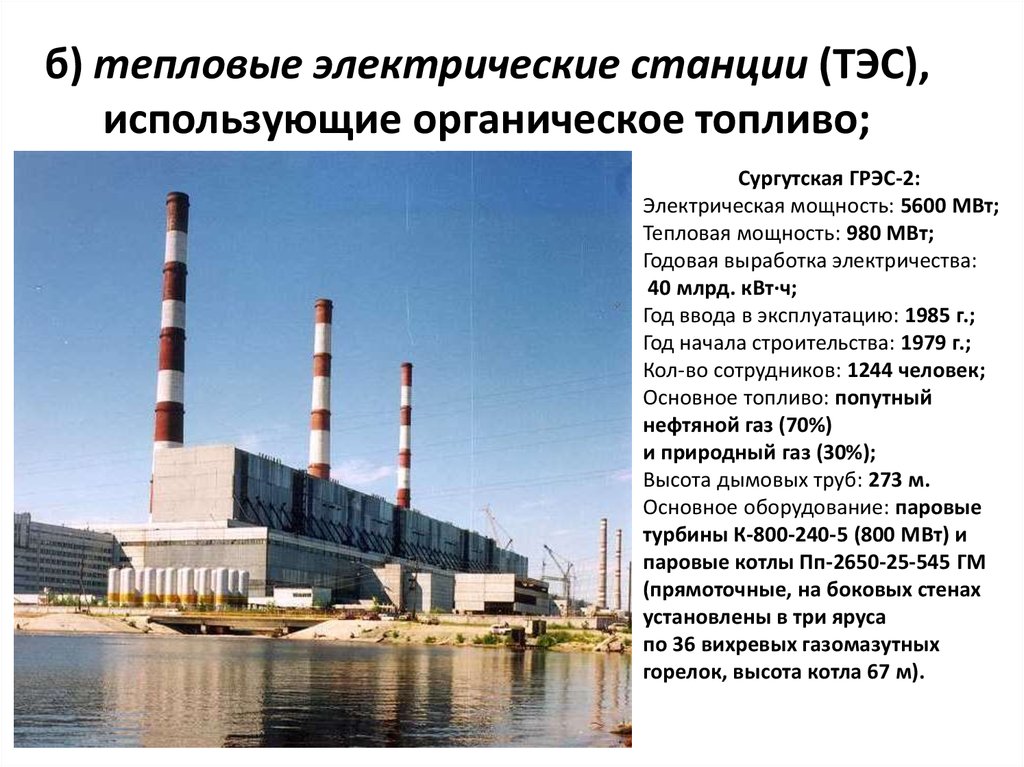

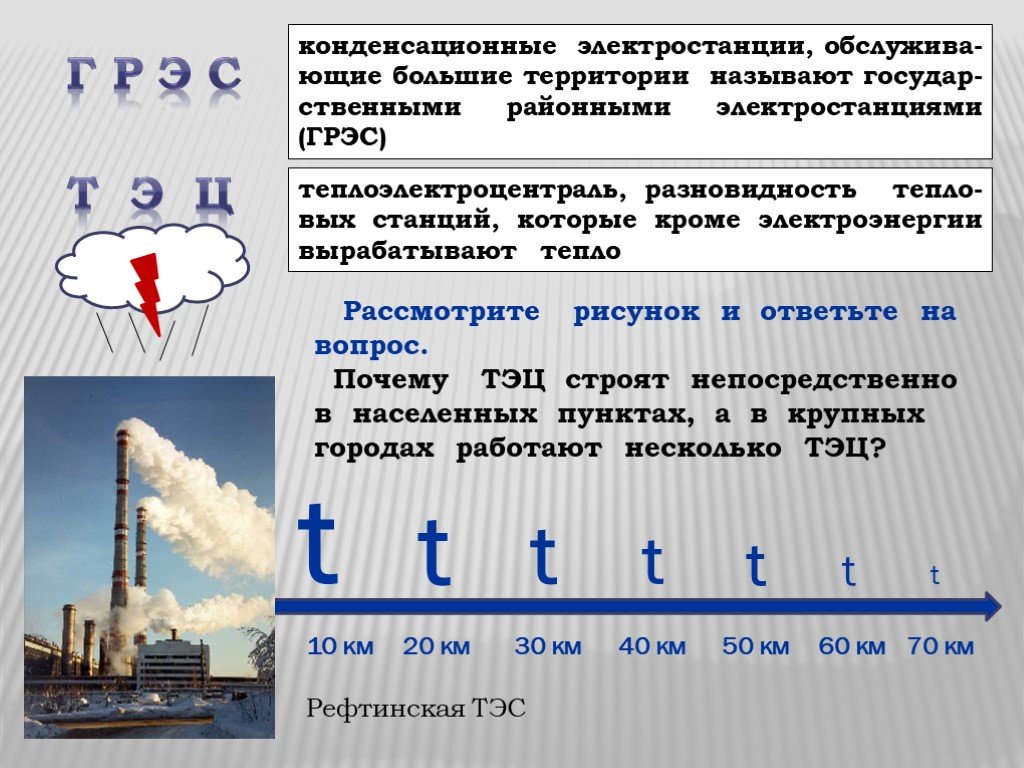

Аббревиатура ГРЭС – это государственная районная электростанция, которая сегодня именуется гораздо проще – конденсационная электростанция.

В качестве основы для выработки служит сжигание топлива, которое при помощи турбин в дальнейшем преобразуется в электроэнергию.

Сегодня они используются для обеспечения электроэнергией города, процентное соотношение в общегосударственной выработке энергии они занимают примерно 30% в странах СНГ.

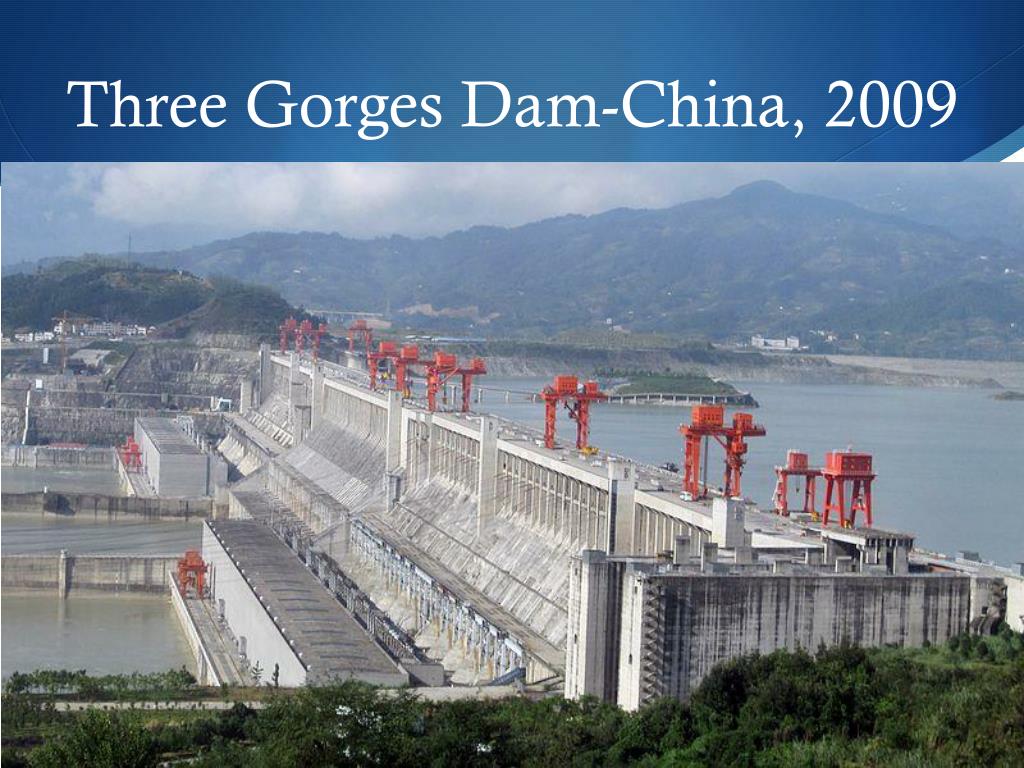

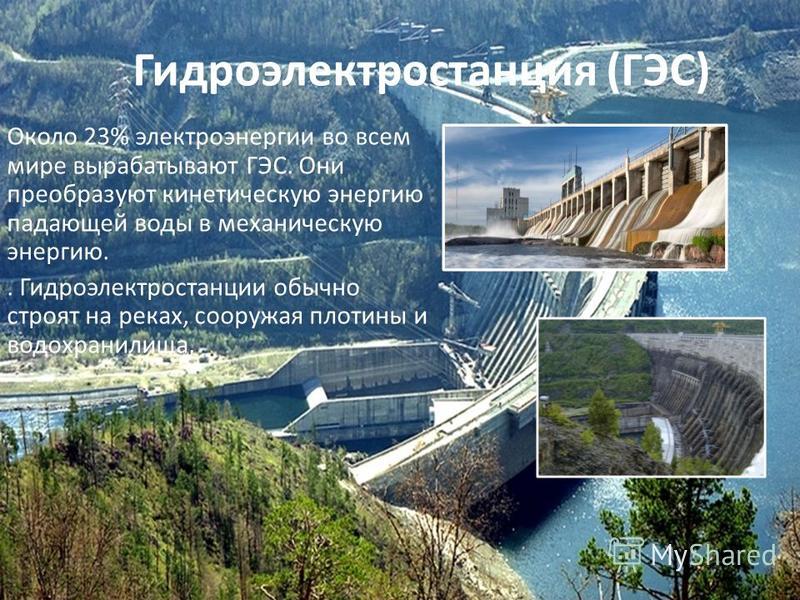

Тогда что такое ГЭС? ГЭС – гидроэлектростанция, которая для выработки электричества использует воду.

Строится на реках или на плотинах. Все чаще прибегают к использованию именно ГЭС, так как выработка электроэнергии при этом происходит максимально экологично, не задевая кардинально флору и фауну.

Расшифровка ГРЭС дает понять, насколько важным был такой вид станций в прошлом, если они строились для районов. В

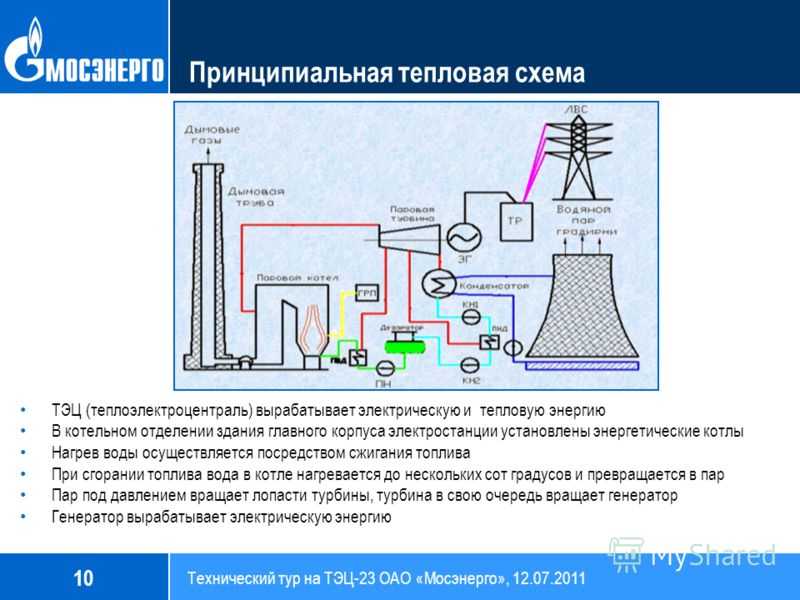

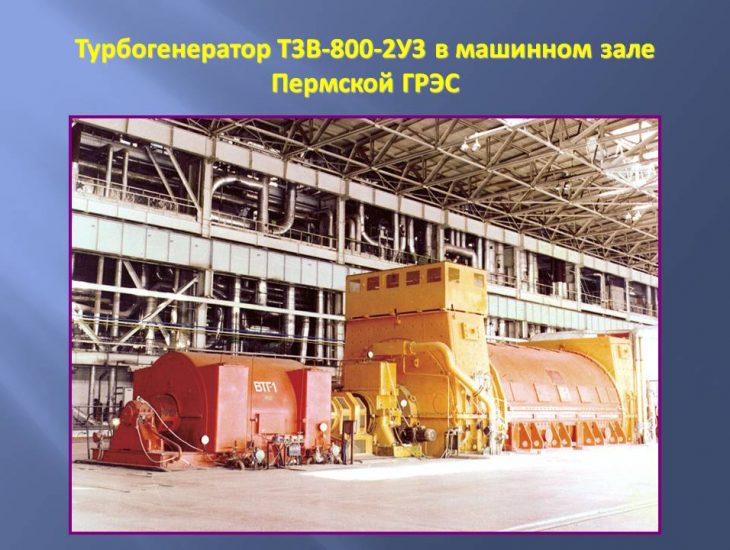

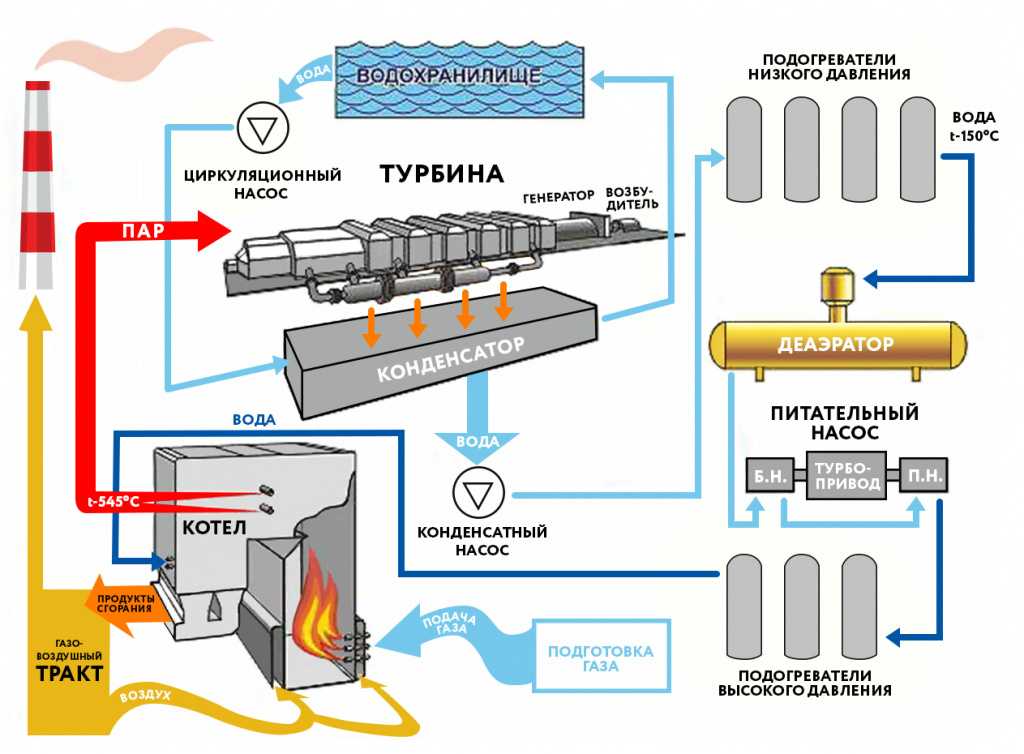

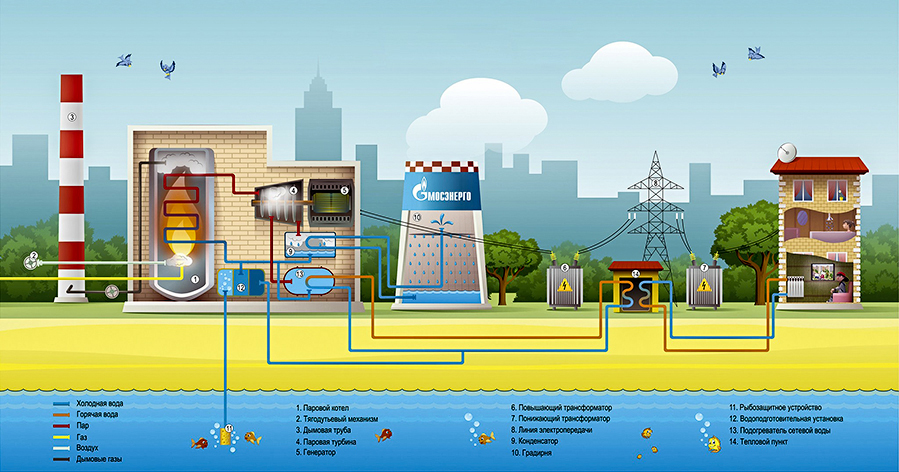

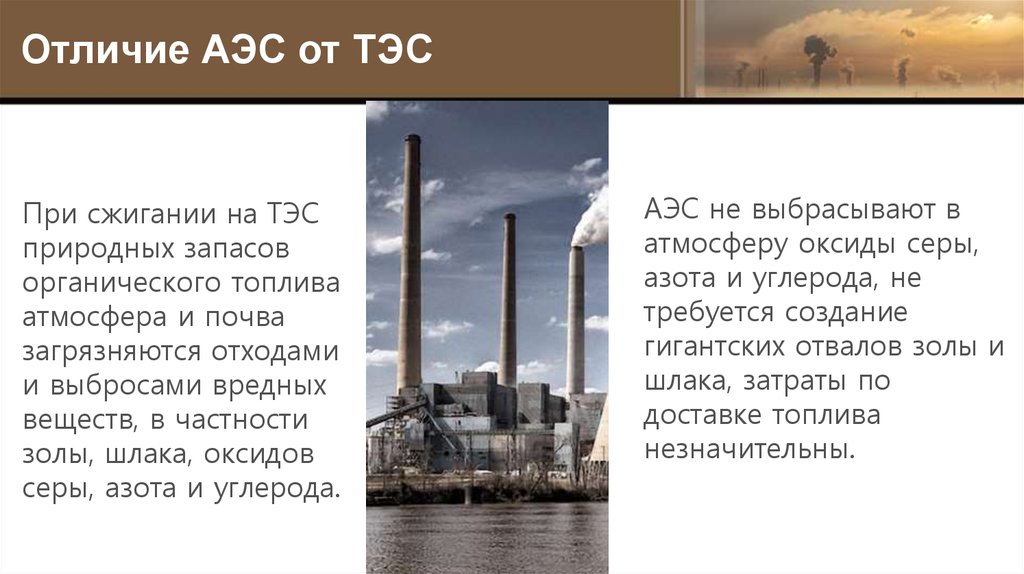

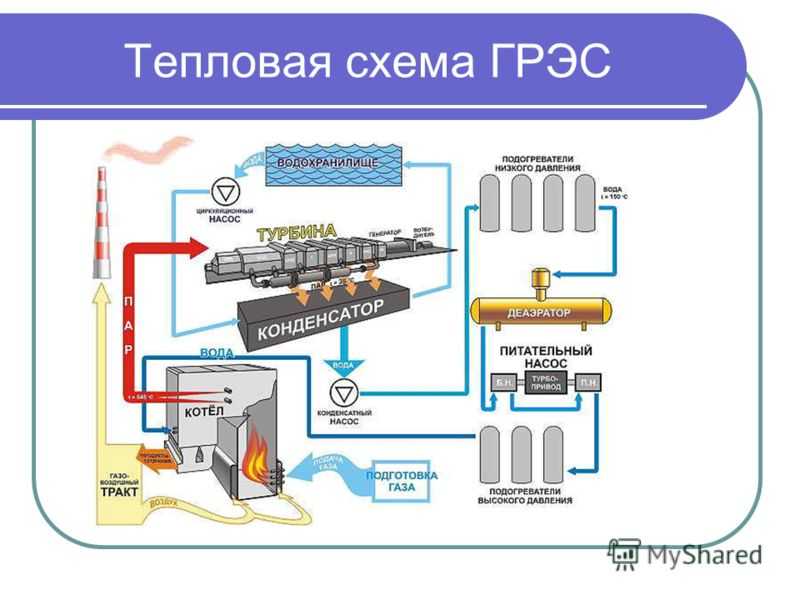

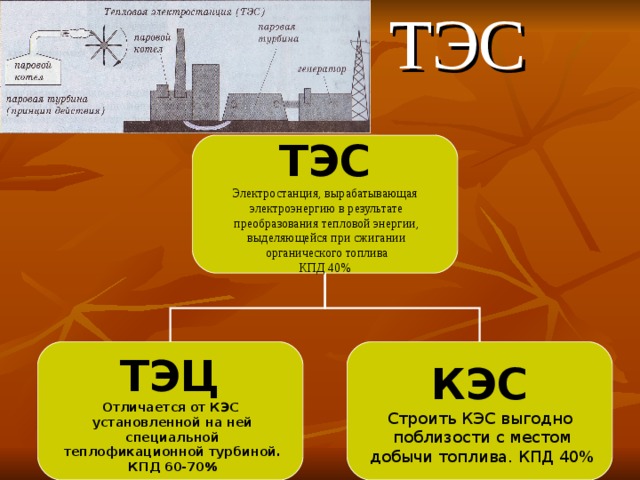

Принцип работы ГРЭС достаточно прост в схеме. Для работы такой электростанции используется твердое топливо – уголь, торф, или газоподобное – газ, все чаще применяться стал мазут. По сути, это обычная тепловая станция, которая производит только электроэнергию и ничего более. По типу различают паровые и парогазовые ГРЭС. Различаются они по типу блоков, а точнее, по их строению.

Паровые ГРЭС используются конденсационные турбины, а в газопаровые ГРЭС турбины применяются только при использовании метана как основного вида топлива. В топке имеется теплообменник, в который залита вода. Именно вода и является главным переносчиком тепла. В дальнейшем вода испаряется, превращаясь в пар, что заставляет крутиться турбину, которая и начинает вырабатывать электричество.

ГРЭС – гораздо более эффективная станция, нежели ГЭС за счет более высокого уровня КПД – примерно 65-70%, в то время в ГЭС КПД на уровне – 45-55% из-за того, что на скорость опадания воды на турбину может влиять холод, жара ветер и т.д.

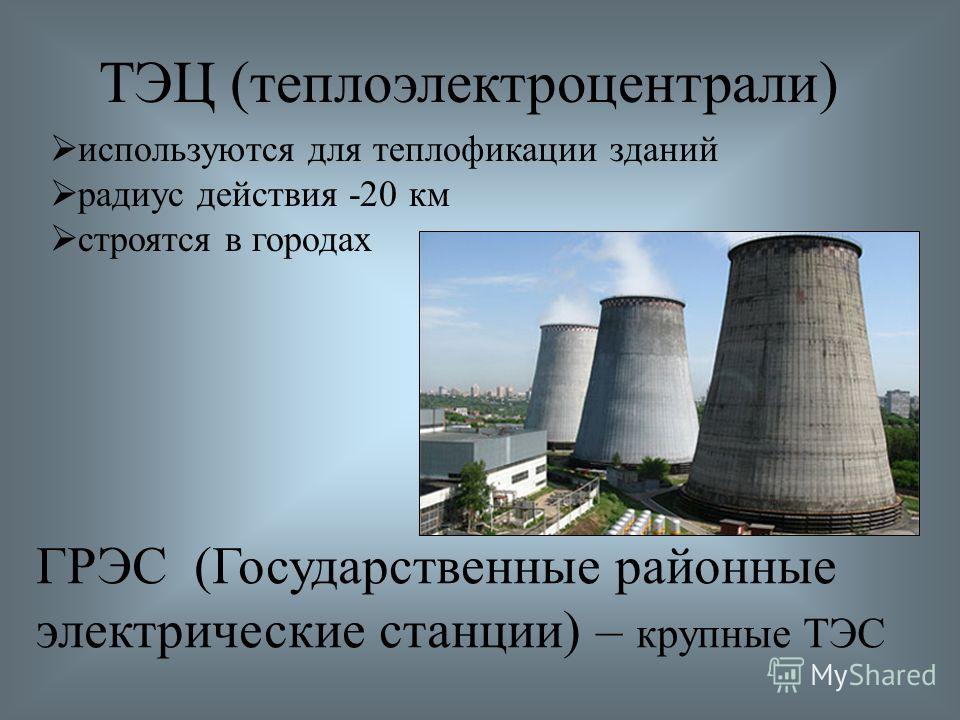

ГЭС что это? Это гидравлическая электростанция, устанавливаемая на реках, чаще на крупных. Для поддержания нужного давления воды в месте расположения ГЭС строятся плотины и другие гидротехнические сооружения.

Принцип работы данной ЭС достаточно прост, вместо топлива турбины крутятся за счет напора воды, проходящего чего них. По сути, осуществляется естественный процесс, при котором вырабатывается энергия. Стоит понимать, что важная составляющая работы ГЭС – правильное проектирование всех основных зданий и сооружений, при котором вода сама будет крутить лопасти.

По сути, осуществляется естественный процесс, при котором вырабатывается энергия. Стоит понимать, что важная составляющая работы ГЭС – правильное проектирование всех основных зданий и сооружений, при котором вода сама будет крутить лопасти.

Отличия ГЭС от ГРЭС – это как сравнивать яблоко и грушу, так как это абсолютно разные по своей природе сооружения. Они разные абсолютно во всем, кроме, наверное, наличия турбины, но даже строение турбины разное, не говоря уже о блоках, накапливающих энергию. Существует 5 основных отличий у этих ЭС:

- В ГЭС используется для выработки электричества энергия потока воды, поэтому они строятся на реках, в то же самое время ГРЭС – могут быть построены везде, где есть железнодорожное сообщение или близкое расположение горючих полезных ископаемых. И для закрепления: ГЭС – гидравлическая электростанция, а ГРЭС – тепловая.

- На ГЭС основная энергия вырабатывается при вращении лопастей турбины при давлении на них напора воды, ГРЭС же работают под напором водяного пара, сила которого около 300 МПа.

- ГЭС используют возобновляемую энергию воду, поэтому КПД во многом зависит от водоема, где установлена станция, его объема и проектирования всей системы, КПД ГРЭС же зависит от типа и качества топлива.

- ГРЭС – более стабильный источник энергии для стран с ярко выраженными холодными и теплыми сезонами, ГЭС же, наоборот, нет, так как в зависимости от температуры изменяется тягучесть воды и, соответственно, скорость ее спадания на лопасти турбины.

- ГРЭ может работать даже при экстремально низких температурах.

Ответ на вопрос, а чем отличается ГЭС от ГРЭС , достаточно банален – всем, начиная от технологии выработки электроэнергии и заканчивая разными по существу источниками для раскрутки лопастей турбин.

Поделиться в соц.сетях:

ТОП-5 крупнейших гидроэлектростанций в России

Более 20% мировой электроэнергии вырабатывается на российских гидроэлектростанциях, при этом страна обладает огромными неиспользованными ресурсами, позволяющими значительно увеличить ее производство. Общая установленная мощность гидроагрегатов на гидроэлектростанциях составляет около 45 млн кВт с годовой выработкой электроэнергии около 165 млрд кВт/ч. Россия владеет 102 гидроэлектростанциями, каждая мощностью более 100 МВт, что ставит страну в число 10 крупнейших гидроэнергетических гигантов мира и на второе место на планете по потенциальному производству энергии. В нашем ТОПе — пятерка самых крупных ГЭС в стране.

Общая установленная мощность гидроагрегатов на гидроэлектростанциях составляет около 45 млн кВт с годовой выработкой электроэнергии около 165 млрд кВт/ч. Россия владеет 102 гидроэлектростанциями, каждая мощностью более 100 МВт, что ставит страну в число 10 крупнейших гидроэнергетических гигантов мира и на второе место на планете по потенциальному производству энергии. В нашем ТОПе — пятерка самых крупных ГЭС в стране.

Богучанская ГЭС

- Мощность: 17,6 ТВтч в год.

Богучанская плотина, расположенная на реке Ангара в Кодинске близ Красноярского края, является пятой по величине в России. Построенная, принадлежащая и эксплуатируемая ОАО «Богучанская ГЭС» (совместное предприятие «Русала» и «РусГидро»), электростанция мощностью 3,0 ГВт вырабатывает в среднем 17,6 ТВтч в год с помощью девяти гидротурбин Фрэнсиса, каждая из которых имеет мощность 333 МВт. После ввода в эксплуатацию девятого генератора в 2015 году энергия в основном направляется на Богучанский алюминиевый завод, в Эвенкийский регион для разработки природных ресурсов (включая леса и другие месторождения полезных ископаемых) и для решения проблемы нехватки электроэнергии в Сибири.

После ввода в эксплуатацию девятого генератора в 2015 году энергия в основном направляется на Богучанский алюминиевый завод, в Эвенкийский регион для разработки природных ресурсов (включая леса и другие месторождения полезных ископаемых) и для решения проблемы нехватки электроэнергии в Сибири.

Усть-Илимская ГЭС

- Мощность: 21,7 ТВтч в год.

Усть-Илимская ГЭС с установленной мощностью 3,8 ГВт является четвертой по величине в России и производит 21,7 ТВтч в год. Эта электростанция, расположенная в Иркутской области, недалеко от Усть-Илимска на реке Ангара, была построена в период с 1963 по 1980 год и принадлежит (как и управляется) «Иркутскэнерго». Огромная бетонная гравитационная плотина состоит из 16 гидротурбин Фрэнсиса, каждая мощностью 240 МВт. К электростанции примыкают две земляные вспомогательные дамбы, построенные в рамках гидроэнергетического проекта. Усть-Илимская ГРЭС может иметь еще две турбины, что сможет увеличить ее установленную мощность до 4,3 ГВт.

Братская ГЭС

- Мощность: 22,6 ТВтч в год.

Братская гидроэлектростанция мощностью 4,5 ГВт находится недалеко от Братска на реке Ангара в Иркутской области на юго-востоке Сибири. Бетонная гравитационная плотина высотой 124,5 м и шириной 924 м построена в период с 1954 по 1961 год, начала работу в 1967 году и производит 22,6 ТВтч в год. На Братской гидроэлектростанции также имеется электростанция, состоящая из 18 гидротурбин Фрэнсиса производства Ленинградского металлургического завода, каждая мощностью 250 МВт. Вершина плотины имеет автомобильную дорогу и колею железнодорожной линии Тайшет-Лена. Хотя у Ангары нет судоходных маршрутов и, следовательно, нет навигационных каналов, в проекте есть возможности для сборки судового лифта.

Красноярская ГЭС

- Мощность: около 23 ТВтч в год.

Красноярская плотина мощностью 6,0 гигаватт (ГВт), построенная между 1956 и 1972 годами, является второй по величине ГЭС в России, построена на реке Енисей в Дивногорске, в 30 км от Красноярска. Гидроэлектростанция вырабатывает 18,4 кВтч электроэнергии в год, большая часть которой поставляется на принадлежащий «Русалу» Красноярский медеплавильный завод. Электростанция Красноярска включает в себя бетонную плотину 1,065 км длиной и 124 м высоты, 12 «Френсисов» мощностью 500 МВт каждого. На электростанции также находится единственный в стране судоподъемник: платформа подъемника движется по зубчатой электрической железной дороге с шириной колеи 9 м.

Гидроэлектростанция вырабатывает 18,4 кВтч электроэнергии в год, большая часть которой поставляется на принадлежащий «Русалу» Красноярский медеплавильный завод. Электростанция Красноярска включает в себя бетонную плотину 1,065 км длиной и 124 м высоты, 12 «Френсисов» мощностью 500 МВт каждого. На электростанции также находится единственный в стране судоподъемник: платформа подъемника движется по зубчатой электрической железной дороге с шириной колеи 9 м.

Саяно-Шушенская ГЭС

- Мощность: 23,5 ТВтч в год.

Крупнейгая гидроэлектростанция в России — один из лучших в мире — Саяно-Шушенская ГЭС построена на реке Енисей в Саяногорск, Хакасия. Плотина была открыта между 1963 и 1978 годами и принадлежит «РусГидро» (второй по величине производитель гидроэлектроэнергии в мире). Установленная мощность арочно-гравитационной плотины электростанции длиной 1066 м и высотой 242 м составляет 6,4 ГВт с 10 гидротурбинами Фрэнсиса мощностью 640 МВт каждая, производящими 23,5 ТВтч в год, из которых львиная доля направляется на четыре алюминиевых завода в Сибири. После серьезного повреждения в результате аварии 2009 года Саяно-Шушенская вернулась на свою обычную производственную мощность в 2014 году после обширного ремонта и модернизации.

После серьезного повреждения в результате аварии 2009 года Саяно-Шушенская вернулась на свою обычную производственную мощность в 2014 году после обширного ремонта и модернизации.

Слушайте: обучение на курсах GE

Хотя Калифорнийский университет в Лос-Анджелесе предлагает широкий спектр образовательных возможностей, один аспект обучения каждого студента бакалавриата остается неизменным: общеобразовательные требования. Эти требования к курсу позволяют студентам, изучающим естественные науки, изучать искусство и гуманитарные науки, а студентам, изучающим историю, изучать естественные и инженерные науки. Требования направлены на то, чтобы сделать учащихся более академически разносторонними. Анхель Перес, советник UCLA Honors, делится некоторыми советами и информацией о курсах GE.

—

РЕДДИ : Северный кампус, где расположены великолепный Ройс-холл, библиотека Пауэлла и внушительный Банч-холл, известен уроками гуманитарных наук и искусств, таких как политология и этномузыкология; Южный кампус включает в себя суд наук с элегантной архитектурой, а также студентов, выстроившихся в очередь перед уроками химии в надежде занять место на предстоящей лекции. Несмотря на то, что 28 000 студентов Калифорнийского университета в Лос-Анджелесе изучают разные предметы и классы, у всех студентов есть одна общая черта: общеобразовательные требования, более известные большинству студентов как GE. Требования GE для Колледжа литературы и науки Калифорнийского университета в Лос-Анджелесе относятся к трем основным направлениям: основы искусств и гуманитарных наук, основы научных исследований и основы общества и культуры. Советник UCLA Honors Student Counsel Анхель Перес считает, что GE является важной частью образования в UCLA, потому что это способ познакомить студентов с другими дисциплинами, сделать их более разносторонними и лучше подготовленными к реальному миру.

Несмотря на то, что 28 000 студентов Калифорнийского университета в Лос-Анджелесе изучают разные предметы и классы, у всех студентов есть одна общая черта: общеобразовательные требования, более известные большинству студентов как GE. Требования GE для Колледжа литературы и науки Калифорнийского университета в Лос-Анджелесе относятся к трем основным направлениям: основы искусств и гуманитарных наук, основы научных исследований и основы общества и культуры. Советник UCLA Honors Student Counsel Анхель Перес считает, что GE является важной частью образования в UCLA, потому что это способ познакомить студентов с другими дисциплинами, сделать их более разносторонними и лучше подготовленными к реальному миру.

ПЕРЕС : Многие студенты-медики говорят: «Я не понимаю, почему мы должны делать все эти GE в Северном кампусе», но чего вы не понимаете, так это пользы, которую вы получите от этих классы, которые могут помочь вам при подаче заявлений в медицинскую школу, при написании отчетов позже, надеюсь, в качестве доктора медицины. Долгосрочные преимущества, которые многие студенты не видят сразу, но в идеале, это должно сделать вас более разносторонним студентом и, возможно, открыть двери для второстепенной или двойной специализации в другой области.

Долгосрочные преимущества, которые многие студенты не видят сразу, но в идеале, это должно сделать вас более разносторонним студентом и, возможно, открыть двери для второстепенной или двойной специализации в другой области.

REDDY: Калифорнийский университет в Лос-Анджелесе предлагает множество GE от LGBTS M137 Лесбиянки, геи, бисексуалы, трансгендеры и квир-перспективы в поп-музыке, до Классики 10, открывая греков, до геронтологии M108 Биомедицинские, социальные и политические границы в старении человека. Некоторые люди выбирают занятия в зависимости от уровня сложности — узнавая, какие занятия легкие, а какие сложные, можно узнать у других учеников и на таких сайтах, как Bruinwalk. Bruinwalk — это собственный веб-сайт Калифорнийского университета в Лос-Анджелесе с рейтингом профессоров и классов, на котором студенты могут оценивать профессоров по сложности, эффективности и доступности. Для таких студентов, как студентка четвертого курса физиологических наук Мартина Шукралла и недавний выпускник факультета психологии Сахар Портахари, уровень сложности играет ключевую роль в принятии решения о том, брать или не посещать занятия по GE.

ШУКРАЛЛА : Я взял то, что мне было бы интересно, но в то же время искал простых профессоров, чтобы получать хорошие оценки. Все мои ГС, которые я когда-либо брал, всегда получали пятерки.

ПОРТОХАРИ : Я не хотел брать что-то скучное, на что я боялся бы учиться, и я также искал учителей в Интернете, чтобы узнать, кто был самым полезным учителем, кто был самым хорошим преподавателем, не буду лгать, самый легкий класс Я мог бы взять, так что это то, что я искал.

РЕДДИ : Учащимся предлагается выбирать занятия, связанные с предметом, который им интересен или к которому они проявляют развивающийся интерес. Подробности уточняет советник по отличием Перес.

ПЕРЕЗ : В идеале поищите то, что вас интересует. Что-то, что вы были бы не против изучить в течение 10 недель, прочитать и пройти тестирование, потому что это именно тот опыт, который вы собираетесь получить. Если вам нравится то, что вы изучаете, вы будете хорошо учиться в этом классе.

РЕДДИ : По словам Переса, многие люди хотят избавиться от ГС, посещая как можно меньше занятий. Один из вариантов для поступающих первокурсников, пытающихся сократить свои классы GE, включает в себя прохождение одного из предлагаемых кластеров GE, годичный интенсивный курс письма, который считается зачетом для четырех GE, выполняет ваше требование по письму II и предлагает кредит с отличием. В рамках каждого из трех фондов предлагается 11 кластеров: есть кластеры, которые отвечают ряду требований GE — некоторые из них, например «Секс: от биологии к гендерному обществу», устраняют некоторые требования к науке и истории, в то время как другие, например, Америка в Шестидесятые: политика, общество и культура, позаботьтесь о некотором историческом анализе и требованиях к искусству.

Различные требования общего образования могут быть сложными для разных учащихся. Существует возможность изменить основу оценивания на «пройдено/не пройдено». Это означает, что вместо получения буквенной оценки, которая учитывается в среднем балле, дается проходной балл для C или выше и отрицательный для C- и ниже. Перес показывает, как эта форма оценивания защищает средний балл. Класс может быть изменен на «зачет/непроход» по URSA, но это необходимо сделать до шестой недели, чтобы избежать дополнительной оплаты или отметки в стенограмме.

Перес показывает, как эта форма оценивания защищает средний балл. Класс может быть изменен на «зачет/непроход» по URSA, но это необходимо сделать до шестой недели, чтобы избежать дополнительной оплаты или отметки в стенограмме.

ПЕРЕЗ: Преимущество состоит в том, чтобы защитить свой средний балл в областях, в которых вы не чувствуете себя настолько сильным. Нет никаких реальных недостатков в прохождении нескольких курсов. Это действительно зависит от вас. Теперь, конечно, вы не хотите, чтобы все ваши GE сдавали «не сдал», и вы не можете взять целую четверть «сдал/не сдал». Должна быть буквенная оценка. Это просто правило. Если побрызгать туда-сюда, негативного воздействия не будет. Вы всегда можете заранее спросить у консультанта, потому что некоторые курсы вы не можете пройти/не пройти.

РЕДДИ : В то время как некоторые студенты считают, что GE необходимы для формирования их университетского образования, другие рассматривают бакалавриат как ступеньку к дальнейшему образованию и возможностям трудоустройства. В результате они могут рассматривать ГС как пустую трату времени. Вот Шон Чонино, студент четвертого курса антропологии.

В результате они могут рассматривать ГС как пустую трату времени. Вот Шон Чонино, студент четвертого курса антропологии.

ЧОНИНО: Моей конечной целью всегда была юридическая школа, и я думаю, что то же самое относится к людям, которые ходят в медицинскую школу, и к людям, которые идут на GRE и доктора философии. Отвечая на ваш вопрос, я считаю, что это излишне.

РЕДДИ : Однако цель общего образования состоит в том, чтобы расширить базовое однонаправленное образование, которое обычно получают в четырехлетнем университете, таком как Калифорнийский университет в Лос-Анджелесе. Это позволяет студенту исследовать другие области и развивать существующие интересы или находить совершенно новые. Многие студенты, такие как Робин Бариос, студент третьего курса психологии, видят эту перспективу и ценят общеобразовательные курсы.

БАРИОС : Я думаю, что они являются преимуществом, потому что они закладывают фундаментальную структуру, на которой вы можете построить больше знаний, и она также очень разнообразна.

РЕДДИ : Независимо от того, пользуются ли студенты преимуществами разнообразия, которое предоставляют GE для своего образования, или берут их просто для выполнения университетских требований, GE по-прежнему обязаны закончить учебу. Имейте в виду, что требования GE различаются для каждого колледжа, и учащиеся должны дважды проверить у своих консультантов, чтобы убедиться, что они записываются на правильные курсы. Консультантов можно найти в офисе академического консультирования колледжа, расположенном в Мерфи-холле A-316, а отличники могут найти консультантов колледжа с отличием, таких как Анхель Перес, в Мерфи-холле A-311. Другой вариант — спросить летнего консультанта по ориентации о GE или просмотреть страницу регистратора классов UCLA, чтобы найти список GE, доступных на предстоящий квартал.

Для Daily Bruin Radio, я Неха Редди.

Slurm Workload Manager — Generic Resource (GRES) Планирование

Содержание

Обзор

Конфигурация

. Работа по работе

Работа по работе

AutodeTect

Управление GPU

Управление MPS

Управление MIG

SHARDING

SUPPARIS

. Общие ресурсы

(ГРЭС). Дополнительные встроенные функции включены для определенных типов GRES,

включая графические процессоры (GPU), многопроцессорную службу CUDA (MPS)

устройств и Sharding с помощью расширяемого механизма подключаемых модулей.

Конфигурация

По умолчанию GRES не включен в конфигурации кластера.

Вы должны явно указать, какие GRES должны управляться в

slurm.conf Файл конфигурации . Параметры конфигурации

интерес представляют GresTypes и Gres .

Дополнительные сведения см. в разделах GresTypes и Gres на справочной странице slurm.conf .

Обратите внимание, что спецификация GRES для каждого узла работает одинаково

как управляются другие ресурсы. Узлы, у которых обнаружено меньше ресурсов

чем настроено, будет переведено в состояние DRAIN.

Фрагмент примера slurm. conf файл:

conf файл:

# Настройте четыре графических процессора (с MPS), а также пропускную способность GresTypes=gpu,mps,пропускная способность NodeName=tux[0-7] Gres=gpu:tesla:2,gpu:kepler:2,mps:400,пропускная способность:lustre:no_consume:4G

Каждый вычислительный узел с общими ресурсами обычно содержит файл gres.conf

файл, описывающий, какие ресурсы доступны на узле, их количество,

связанные файлы устройств и ядра, которые должны использоваться с этими ресурсами.

Есть случаи, когда вы можете захотеть определить общий ресурс на узле.

без указания количества этой ГРЭС. Например, тип файловой системы

узла не уменьшается в цене по мере выполнения заданий на этом узле.

Вы можете использовать флаг no_consume , чтобы разрешить пользователям запрашивать GRES.

без определенного счетчика, который используется по мере запроса.

Чтобы просмотреть доступные параметры конфигурации gres.conf , см.

справочная страница gres.conf.

Выполнение заданий

Заданиям не будут выделяться какие-либо общие ресурсы, за исключением специально

запрашивается во время отправки задания с использованием параметров:

- —gres

- Общие ресурсы, необходимые для каждого узла

- —gpus

- графических процессоров

- —gpus-на узел

- графических процессоров.

Эквивалент параметра —gres для графических процессоров.

Эквивалент параметра —gres для графических процессоров. - —gpus-на-сокет

- графических процессоров. Требует, чтобы задание указывало сокет задачи.

- —gpus-на-задачу

- графических процессоров. Требует, чтобы задание указывало количество задач.

Для каждого задания требуется

На узел требуется

На сокет требуется

Для каждой задачи требуется

Все эти опции поддерживаются salloc , sbatch и

srun команд.

Обратите внимание, что все параметры —gpu* поддерживаются только Slurm.

плагин select/cons_tres.

Задания, запрашивающие эти параметры, когда плагин select/cons_tres имеет значение , а не .

настроенный будет отклонен.

—gres опция требует аргумент, указывающий, какие общие ресурсы

требуется и сколько ресурсов с использованием формы имя[:тип:количество]

в то время как все параметры —gpu* требуют аргумента формы

[тип]:количество .

Имя совпадает с именем

определяется параметрами конфигурации GresTypes и Gres .

тип идентифицирует конкретный тип этого универсального ресурса (например,

конкретной модели графического процессора).

счет указывает, сколько ресурсов требуется, и имеет значение по умолчанию.

значение 1. Например:

sbatch —gres=gpu:kepler:2 … .

Доступны несколько спецификаций дополнительных требований к ресурсам

специально для графических процессоров, а подробные описания этих параметров см.

доступны на справочных страницах для команд отправки задания.

Что касается опции —gpu* , эти опции поддерживаются только Slurm.

плагин select/cons_tres.

- —cpus-per-gpu

- Количество ЦП, выделенных на GPU.

- —gpu-связать

- Определите, как задачи привязываются к графическим процессорам.

- —частота GPU

- Укажите частоту графического процессора и/или частоту памяти графического процессора.

- —mem-per-gpu

- Память, выделенная для каждого графического процессора.

Заданиям будут выделяться определенные общие ресурсы по мере необходимости для удовлетворения

запрос. Если задание приостановлено, эти ресурсы становятся недоступными.

для использования другими работами.

Шагам задания могут быть назначены общие ресурсы из ресурсов, выделенных для

задание с использованием параметра —gres с командой srun , как описано

выше. По умолчанию шагу задания будут выделены все общие ресурсы.

отводится на работу. При желании шаг задания может явно указывать

общее количество ресурсов, отличное от задания.

Этот выбор дизайна был основан на сценарии, в котором каждое задание выполняет множество

шаги работы. Если шагам задания был предоставлен доступ ко всем универсальным ресурсам

по умолчанию для некоторых шагов задания необходимо явно указать нулевой общий ресурс

подсчеты, которые мы считали более запутанными. Шаг задания может быть выделен

определенные общие ресурсы, и эти ресурсы не будут доступны для других

шаги работы. Простой пример показан ниже.

Простой пример показан ниже.

#!/бин/баш # # gres_test.bash # Отправьте следующим образом: # sbatch --gres=gpu:4 -n4 -N1-1 gres_test.bash # srun --gres=gpu:2 -n2 --exclusive show_device.sh & srun --gres=gpu:1 -n1 --exclusive show_device.sh & srun --gres=gpu:1 -n1 --exclusive show_device.sh & ждать

Автоматическое обнаружение

Если AutoDetect=nvml или AutoDetect=rsmi установлены

gres.conf и соответствующие библиотеки управления GPU установлены

на узле и обнаруженные во время настройки Slurm, детали конфигурации будут

автоматически заполняется для любого обнаруженного системой GPU. Это устраняет необходимость

явно настроить GPU в gres.conf, хотя Gres= строк в

slurm.conf по-прежнему требуется, чтобы сообщить slurmctld, сколько GRES ожидать.

По умолчанию к узлу добавляются все обнаруженные системой устройства.

Однако, если Тип и Файл в gres.conf соответствуют графическому процессору на

система, любые другие явно указанные свойства (например,

Cores или Links ) можно перепроверить по нему.

Если обнаруженный системой графический процессор отличается от соответствующей ему конфигурации графического процессора,

GPU отсутствует в узле с ошибкой.

Это позволяет gres.conf для дополнительной проверки работоспособности и уведомления

администраторам любых неожиданных изменений в свойствах графического процессора.

Если не все обнаруженные системой устройства указаны в slurm.conf

конфигурации, то соответствующий slurmd будет слит. Тем не менее, это все еще

можно использовать подмножество устройств, найденных в системе, если они

указывается вручную (с отключенным AutoDetect) в gres.conf.

Пример Файл gres.conf :

# Настройте четыре графических процессора (с MPS), а также пропускную способность Автоопределение=nvml Имя=gpu Тип=gp100 Файл=/dev/nvidia0 Ядра=0,1 Имя=gpu Тип=gp100 Файл=/dev/nvidia1 Ядра=0,1 Имя=тип GPU=p6000 Файл=/dev/nvidia2 Ядра=2,3 Имя=тип GPU=p6000 Файл=/dev/nvidia3 Ядра=2,3 Имя=число mps=200 Файл=/dev/nvidia0 Имя=mps Количество=200 Файл=/dev/nvidia1 Имя=mps Количество=100 Файл=/dev/nvidia2 Имя=mps Количество=100 Файл=/dev/nvidia3 Имя=пропускная способность Тип=блеск Количество=4G Флаги=CountOnly

В этом примере, поскольку указано AutoDetect=nvml , ядер

для каждого графического процессора будет сверяться с соответствующим графическим процессором, найденным в системе.

соответствующий указанному типу и файлу .

Так как Ссылка не указана, она будет автоматически заполнена

в соответствии с тем, что найдено в системе.

Если соответствующий системный графический процессор не найден, проверка не выполняется, и графический процессор

предполагается, как говорится в конфигурации.

На Введите , чтобы соответствовать обнаруженному системой устройству, он должен либо точно

совпадать или быть подстрокой имени графического процессора, сообщаемого slurmd через AutoDetect

механизм. В этом имени графического процессора все пробелы будут заменены символами подчеркивания. Увидеть

имя графического процессора, установите SlurmdDebug=debug2 в вашем slurm.conf и либо

перезапустите или перенастройте slurmd и проверьте журнал slurmd. Например,

с AutoDetect=nvml :

отладка: gpu/nvml: init: init: загружен плагин GPU NVML debug2: gpu/nvml: _nvml_init: успешно инициализирован NVML отладка: gpu/nvml: _get_system_gpu_list_nvml: версия системного графического драйвера: 450.36.06 отладка: gpu/nvml: _get_system_gpu_list_nvml: Версия библиотеки NVML: 11.450.36.06 debug2: gpu/nvml: _get_system_gpu_list_nvml: Общее количество процессоров: 6 debug2: gpu/nvml: _get_system_gpu_list_nvml: Количество устройств: 1 debug2: gpu/nvml: _get_system_gpu_list_nvml: индекс графического процессора 0: debug2: gpu/nvml: _get_system_gpu_list_nvml: Имя: geforce_rtx_2060 debug2: gpu/nvml: _get_system_gpu_list_nvml: UUID: GPU-g44ef22a-d954-c552-b5c4-7371354534b2 debug2: gpu/nvml: _get_system_gpu_list_nvml: домен PCI/шина/устройство: 0:1:0 debug2: gpu/nvml: _get_system_gpu_list_nvml: идентификатор шины PCI: 00000000:01:00.0 debug2: gpu/nvml: _get_system_gpu_list_nvml: NVLinks: -1 debug2: gpu/nvml: _get_system_gpu_list_nvml: файл устройства (дополнительный номер): /dev/nvidia0 debug2: gpu/nvml: _get_system_gpu_list_nvml: Диапазон соответствия ЦП — машина: 0-5 debug2: gpu/nvml: _get_system_gpu_list_nvml: Core Affinity Range — Abstract: 0–5

В этом примере имя графического процессора указывается как

geforce_rtx_2060 . Итак, в вашем slurm.conf и

Итак, в вашем slurm.conf и

gres.conf, тип GPU может быть установлен на

джифорс ртх ,

2060 geforce_rtx_2060 , или любой другой

подстрока, и slurmd должен быть в состоянии сопоставить ее с обнаруженным системой

устройство geforce_rtx_2060 .

Управление графическим процессором

В случае подключаемого модуля Slurm GRES для графических процессоров переменная среды

CUDA_VISIBLE_DEVICES

устанавливается для каждого шага задания, чтобы определить, какие графические процессоры

доступным для использования на каждом узле. Эта переменная среды устанавливается только

когда задачи запускаются на конкретном вычислительном узле (без глобальной среды

переменная установлена для команды salloc , а переменная окружения установлена

для команды sbatch отображаются только графические процессоры, выделенные для этого задания.

на этом узле, нулевой узел выделения).

CUDA версии 3.1 (или выше) использует эту среду

переменная для запуска нескольких заданий или шагов задания на узле с графическими процессорами

и убедитесь, что ресурсы, назначенные каждому, уникальны. В примере

выше, выделенный узел может иметь четыре или более графических устройства. В этом

случай, CUDA_VISIBLE_DEVICES

будет ссылаться на уникальные устройства для каждого файла и

вывод может выглядеть так:

Шаг задания=1234.0 CUDA_VISIBLE_DEVICES=0,1 Шаг задания=1234.1 CUDA_VISIBLE_DEVICES=2 Шаг задания=1234.2 CUDA_VISIBLE_DEVICES=3

ПРИМЕЧАНИЕ. Обязательно укажите параметры файла в файле gres.conf

файл и убедитесь, что они расположены в порядке возрастания номеров.

CUDA_VISIBLE_DEVICES

переменная окружения также будет установлена в программах Prolog и Epilog задания.

Обратите внимание, что набор переменных среды для задания может отличаться от набора для

Пролог и Эпилог, если Slurm настроен на ограничение файлов устройств

виден для задания, использующего cgroup Linux.

Это связано с тем, что программы Пролога и Эпилога выполняются вне любого Linux

cgroup, в то время как задание выполняется 90 136 внутри 90 137 cgroup и, таким образом, может иметь

другой набор видимых устройств.

Например, если для задания выделено устройство «/dev/nvidia1», то

CUDA_VISIBLE_DEVICES будет установлено значение

«1» в прологе и эпилоге, а значение задания равно

CUDA_VISIBLE_DEVICES будет установлен в

значение «0» (т. е. первое устройство GPU, видимое для задания).

Для получения дополнительной информации см.

Руководство по прологу и эпилогу.

Когда это возможно, Slurm автоматически определяет графические процессоры в системе, используя

НВМЛ. NVML (который питает

инструмент nvidia-smi ) нумерует графические процессоры в порядке их

Идентификаторы шины PCI. Чтобы эта нумерация соответствовала нумерации, сообщаемой CUDA,

CUDA_DEVICE_ORDER переменная среды должна

быть установлен на CUDA_DEVICE_ORDER=PCI_BUS_ID .

Файлы устройств GPU (например, /dev/nvidia1 )

на основе присвоения младших номеров Linux, в то время как номера устройств NVML

назначается через идентификатор шины PCI, от низшего к высшему. Сопоставление между этими двумя

недетерминированные и зависящие от системы, и могут различаться между загрузками после

изменения оборудования или ОС. По большей части это назначение кажется довольно стабильным.

Однако требуется проверка после загрузки, чтобы гарантировать, что устройство GPU

назначается конкретному файлу устройства.

Пожалуйста, обратитесь к

Документация NVIDIA CUDA для получения дополнительной информации о

CUDA_VISIBLE_DEVICES и

CUDA_DEVICE_ORDER переменные окружения.

Управление MPS

CUDA Multi-Process Service (MPS) предоставляет механизм, с помощью которого графические процессоры могут быть

разделены несколькими заданиями, где каждому заданию выделяется некоторый процент

ресурсы графического процессора.

Общее количество ресурсов MPS, доступных на узле, должно быть настроено в

файл slurm.conf (например, «NodeName=tux[1-16] Gres=gpu:2,mps:200»).

Доступно несколько вариантов настройки MPS в файл gres.conf

как указано ниже со следующими примерами:

- Без конфигурации MPS: Количество элементов gres/mps, определенных в

slurm.conf будет равномерно распределен по всем графическим процессорам, настроенным на

узел. Например, «NodeName=tux[1-16] Gres=gpu:2,mps:200» настроит

количество ресурсов 100 gres/mps на каждом из двух графических процессоров. - MPS включает только параметры Name и Count :

Количество элементов gres/mps будет равномерно распределено по всем графическим процессорам.

настроен на узле. Это похоже на случай 1, но дублирует

конфигурация в файле gres.conf. - MPS включает Имя , Файл и Счетчик

параметры: каждый параметр File должен указывать путь к файлу устройства

GPU и Count должны определять количество ресурсов gres/mps.

доступны для этого конкретного устройства с графическим процессором.

Это может быть полезно в гетерогенной среде.

Например, некоторые графические процессоры на узле могут быть более мощными, чем другие, и поэтому

связано с более высоким количеством gres/mps.

Другим вариантом использования может быть предотвращение использования некоторых графических процессоров для MPS (т.

у них будет нулевой счетчик MPS).

Конфигурация

Конфигурация

Обратите внимание, что параметры Type и Cores для gres/mps игнорируются.

Эта информация копируется из конфигурации gres/gpu.

Обратите внимание, что параметр Count переводится в проценты, поэтому значение

обычно кратно 100.

Обратите внимание, что если установлена библиотека NVIDIA NVML, конфигурация графического процессора

(т. е. Type , File , Cores и Links data) будет

автоматически собирается из библиотеки и не требует записи в

файл gres.conf .

Обратите внимание, что один и тот же графический процессор может быть назначен либо как тип графического процессора GRES, либо как

ГРЭС типа MPS, но не то и другое одновременно.

Другими словами, как только GPU был выделен как ресурс gres/gpu, он будет

не будет доступен как gres/mps.

Аналогичным образом, как только GPU будет выделен как ресурс gres/mps, он будет

не будет доступен как gres/gpu.

Однако один и тот же графический процессор может быть выделен как общие ресурсы MPS для нескольких заданий.

принадлежащих нескольким пользователям, при условии, что общее количество MPS, выделенных для

заданий не превышает настроенного количества.

Кроме того, поскольку совместно используемая GRES (MPS) не может быть выделена одновременно с

GRES (GPU) этот параметр выделяет только все общие ресурсы GRES, а не базовые общие ресурсы.

ГРЭС.

Некоторые примеры конфигураций файла gres.conf Slurm показаны ниже.

# Пример 1 файла gres.conf # Настроить четыре графических процессора (с MPS) Автоопределение=nvml Имя=gpu Тип=gp100 Файл=/dev/nvidia0 Ядра=0,1 Имя=gpu Тип=gp100 Файл=/dev/nvidia1 Ядра=0,1 Имя=тип GPU=p6000 Файл=/dev/nvidia2 Ядра=2,3 Имя=тип GPU=p6000 Файл=/dev/nvidia3 Ядра=2,3 # Установите значение gres/mps Count равным 100 на каждом из 4 доступных графических процессоров.Имя=количество миль в секунду=400

# Пример 2 файла gres.conf # Настроить четыре разных типа графических процессоров (с MPS) Автоопределение=nvml Имя=тип GPU=gtx1080 Файл=/dev/nvidia0 Ядра=0,1 Имя=GPU Тип=gtx1070 Файл=/dev/nvidia1 Ядра=0,1 Имя=тип GPU=gtx1060 Файл=/dev/nvidia2 Ядра=2,3 Имя=тип GPU=gtx1050 Файл=/dev/nvidia3 Ядра=2,3 Имя=число mps=1300 Файл=/dev/nvidia0 Имя=число mps=1200 Файл=/dev/nvidia1 Имя=число mps=1100 Файл=/dev/nvidia2 Имя=mps Количество=1000 Файл=/dev/nvidia3

ПРИМЕЧАНИЕ. gres/mps требует использования select/cons_tres

плагин.

Запросы заданий для MPS будут обрабатываться так же, как и для любых других GRES, за исключением

что запрос должен быть удовлетворен с использованием только одного графического процессора на узел и только одного

Графический процессор на узел может быть настроен для использования с MPS.

Например, запрос задания для «—gres=mps:50» не будет удовлетворен при использовании

20 процентов одного графического процессора и 30 процентов второго графического процессора на одном узле.

Несколько заданий от разных пользователей могут одновременно использовать MPS на узле.

Обратите внимание, что GRES типы GPU и MPS не могут быть запрошены в течение

одна работа.

Также задания, запрашивающие ресурсы MPS, не могут указывать частоту графического процессора.

Для запуска и остановки серверов MPS по мере необходимости следует использовать пролог-программу.

Пример сценария пролога для этого включен в дистрибутив Slurm в

местоположение etc/prolog.example .

Его режим работы: если для задания выделены ресурсы gres/mps, то

Пролог будет иметь CUDA_VISIBLE_DEVICES ,

CUDA_MPS_ACTIVE_THREAD_PERCENTAGE и

Установлены переменные среды SLURM_JOB_UID .

Затем Prolog должен убедиться, что сервер MPS запущен для этого графического процессора.

и пользователя (UID == ID пользователя).

Он также записывает идентификатор устройства GPU в локальный файл.

Если для задания выделены ресурсы gres/gpu, тогда Пролог будет иметь

CUDA_VISIBLE_DEVICES и

SLURM_JOB_UID набор переменных среды

(нет CUDA_MPS_ACTIVE_THREAD_PERCENTAGE ).

Затем Пролог должен завершить любой сервер MPS, связанный с этим графическим процессором.

Возможно, потребуется изменить этот сценарий, если это необходимо для локальной среды.

Для получения дополнительной информации см.

Руководство по прологу и эпилогу.

Задания, запрашивающие ресурсы MPS, будут иметь

CUDA_VISIBLE_DEVICES

и CUDA_DEVICE_ORDER набор переменных окружения.

Идентификатор устройства относится к тем ресурсам, которые находятся под контролем сервера MPS, и будет

всегда имеют нулевое значение в текущей реализации (только один GPU будет

может использоваться в режиме MPS на узел).

Работа также будет иметь

CUDA_MPS_ACTIVE_THREAD_PERCENTAGE

переменная среды, установленная на процент ресурсов MPS, доступных для этого задания на

назначенный графический процессор.

Процент будет рассчитываться на основе части настроенного

Граф на Гресе отведен на задание шага.

Например, задание, запрашивающее «—gres=gpu:200» и использующее

пример конфигурации 2 выше будет

выделено

15% gtx1080 (файл =/dev/nvidia0, 200 x 100/1300 = 15), или

16% gtx1070 (файл =/dev/nvidia0, 200 x 100/1200 = 16), или

18 % от gtx1060 (файл=/dev/nvidia0, 200 x 100/1100 = 18) или

20% от gtx1050 (файл=/dev/nvidia0, 200 x 100/1000 = 20).

Альтернативным режимом работы может быть разрешение распределения заданий целиком

Затем графические процессоры инициируют запуск сервера MPS на основе комментариев в задании.

Например, если для задания выделены целые графические процессоры, выполните поиск комментария

«mps-per-gpu» или «mps-per-node» в задании (используя «scontrol show job»

команда) и используйте ее в качестве основы для запуска одного демона MPS на GPU или в

все графические процессоры соответственно.

Пожалуйста, обратитесь к

Документация по многопроцессорной службе NVIDIA для получения дополнительной информации о MPS.

Обратите внимание, что в предыдущих версиях драйвера NVIDIA существует уязвимость, которая

может повлиять на пользователей при совместном использовании графических процессоров. Дополнительную информацию можно найти в

CVE-2018-6260 и в

Бюллетень по безопасности: Драйвер дисплея графического процессора NVIDIA — февраль 2019 г.

NVIDIA MPS имеет встроенное ограничение на совместное использование графического процессора различными

пользователи. Только один пользователь в системе может иметь активный сервер MPS.

Только один пользователь в системе может иметь активный сервер MPS.

управляющий демон будет ставить в очередь запросы на активацию сервера MPS от отдельных пользователей,

что приводит к сериализованному эксклюзивному доступу к графическому процессору между пользователями (см.

Раздел 2.3.1.1 — Ограничения в документах MPS). Таким образом, разные пользователи не могут

по-настоящему работать одновременно на графическом процессоре с MPS; скорее, GPU будет разрезан по времени

между пользователями (схему этого процесса см.

Раздел 3.3 — Последовательность подготовки в документах MPS).

Управление МИГ

Начиная с версии 21.08, Slurm теперь поддерживает NVIDIA

Устройства Multi-Instance GPU (MIG). Эта функция позволяет некоторым новым NVIDIA

Графические процессоры (например, A100) для разделения графического процессора на семь отдельных изолированных графических процессоров.

экземпляры. Slurm может рассматривать эти экземпляры MIG как отдельные графические процессоры с

изоляция cgroup и привязка задач.

Чтобы настроить MIG в Slurm, укажите

AutoDetect=nvml в gres.conf для

узлы с MIG и указать Гресь

в slurm.conf , как если бы MIG были обычными графическими процессорами. Необязательный

Можно указать тип GRES, чтобы отличать MIG разных размеров от каждого

другой, а также от других графических процессоров в кластере. Этот тип должен быть подстрокой

строки «MIG Profile», как сообщает узел в своем журнале slurmd под

отладка2 уровень журнала. Другие атрибуты MIG будут

также отображается, включая MIG UUID, идентификатор экземпляра графического процессора (GI), вычислительный экземпляр

(CI) ID, второстепенные номера GI и CI, связанные файлы устройств MIG и

«UniqueID» (значение, которое Slurm будет использовать для выбора MIG через

CUDA_VISIBLE_DEVICES ).

Параметр MultipleFiles

позволяет указать несколько файлов устройств для карты GPU.

Режим проверки работоспособности AutoDetect не поддерживается для MIG.

Slurm ожидает, что устройства MIG уже разделены на разделы, и не поддерживает

динамическое разбиение MIG.

Для получения дополнительной информации о NVIDIA MIG (включая их разделение) см.

руководство пользователя МИГ.

Шардинг

Разделение обеспечивает общий механизм, с помощью которого графические процессоры могут быть

разделяется несколькими работами. Хотя он позволяет выполнять несколько заданий на заданном

GPU не ограждает процессы, запущенные на GPU, а только разрешает GPU

быть разделены. Таким образом, сегментирование лучше всего работает с однородными рабочими процессами. это

рекомендуется ограничить количество осколков на узле, чтобы оно равнялось максимально возможному

задания, которые могут выполняться одновременно на узле (т. е. ядрах).

Общее количество шардов, доступных на узле, должно быть настроено в

файл slurm.conf (например, «NodeName=tux[1-16] Gres=gpu:2,shard:64»).

Доступно несколько вариантов настройки осколков в файле gres.conf .

как указано ниже со следующими примерами:

- Конфигурация No Shard: Количество элементов gres/shard, определенных в

slurm.conf будет равномерно распределен по всем графическим процессорам, настроенным на

узел. Например, «NodeName=tux[1-16] Gres=gpu:2,shard:64» настроит

количество ресурсов gres/shard составляет 32 на каждом из двух графических процессоров. - Shard включает только параметры Name и Count :

Количество элементов gres/shard будет равномерно распределено по всем графическим процессорам.

настроен на узле. Это похоже на случай 1, но дублирует

конфигурация в файле gres.conf. - включает Имя , Файл и Количество

параметры: каждый параметр File должен указывать путь к файлу устройства

ГП и Счетчик должен определять количество ресурсов gres/shard.

доступны для этого конкретного устройства с графическим процессором.

Это может быть полезно в гетерогенной среде.

Например, некоторые графические процессоры на узле могут быть более мощными, чем другие, и поэтому

связано с более высоким количеством gres/shard.

Другим вариантом использования может быть предотвращение использования некоторых графических процессоров для сегментирования (т.

у них будет нулевой счетчик осколков).

Конфигурация

Конфигурация сегмента

Обратите внимание, что параметры Type и Cores для gres/shard игнорируются.

Эта информация копируется из конфигурации gres/gpu.

Обратите внимание, что если установлена библиотека NVIDIA NVML, конфигурация графического процессора

(т. е. Type , File , Cores и Links data) будет

автоматически собирается из библиотеки и не требует записи в

файл gres.conf .

Обратите внимание, что один и тот же графический процессор может быть назначен либо как тип графического процессора GRES, либо как

тип осколка GRES, но не то и другое одновременно.

Другими словами, как только GPU был выделен как ресурс gres/gpu, он будет

не будет доступен как gres/shard.

Аналогичным образом, как только GPU будет выделен как ресурс gres/shard, он будет

не будет доступен как gres/gpu.

Однако один и тот же графический процессор может быть выделен в качестве общих ресурсов сегмента для нескольких заданий.

принадлежащих нескольким пользователям, если общее количество SHARD, выделенных для

заданий не превышает настроенного количества.

Для правильной настройки нужны соответствующие узлы

добавить ключевое слово shard в качестве GRES для соответствующих узлов, как

а также добавляется к параметру GresTypes . Если вы хотите осколки

чтобы отследить в бухгалтерии то осколок тоже нужно добавить в

Бухгалтерское хранилищеTRES .

См. соответствующие настройки в примере slurm.conf:

AccountingStorageTRES=gres/gpu,gres/shard GresTypes=gpu,осколок NodeName=tux[1-16] Gres=gpu:2,shard:64

Некоторые примеры конфигураций файла gres.conf Slurm показаны ниже.

# Пример 1 файла gres.conf

# Настроить четыре графических процессора (с шардингом)

Автоопределение=nvml

Имя=gpu Тип=gp100 Файл=/dev/nvidia0 Ядра=0,1

Имя=gpu Тип=gp100 Файл=/dev/nvidia1 Ядра=0,1

Имя=тип GPU=p6000 Файл=/dev/nvidia2 Ядра=2,3

Имя=тип GPU=p6000 Файл=/dev/nvidia3 Ядра=2,3

# Установите значение gres/shard Count равным 8 на каждом из 4 доступных графических процессоров.Гэс и грэс отличия: ГРЭС и ГЭС — что это, как расшифровывается и их отличия

Эквивалент параметра —gres для графических процессоров.

Эквивалент параметра —gres для графических процессоров.

36.06

отладка: gpu/nvml: _get_system_gpu_list_nvml: Версия библиотеки NVML: 11.450.36.06

debug2: gpu/nvml: _get_system_gpu_list_nvml: Общее количество процессоров: 6

debug2: gpu/nvml: _get_system_gpu_list_nvml: Количество устройств: 1

debug2: gpu/nvml: _get_system_gpu_list_nvml: индекс графического процессора 0:

debug2: gpu/nvml: _get_system_gpu_list_nvml: Имя: geforce_rtx_2060

debug2: gpu/nvml: _get_system_gpu_list_nvml: UUID: GPU-g44ef22a-d954-c552-b5c4-7371354534b2

debug2: gpu/nvml: _get_system_gpu_list_nvml: домен PCI/шина/устройство: 0:1:0

debug2: gpu/nvml: _get_system_gpu_list_nvml: идентификатор шины PCI: 00000000:01:00.0

debug2: gpu/nvml: _get_system_gpu_list_nvml: NVLinks: -1

debug2: gpu/nvml: _get_system_gpu_list_nvml: файл устройства (дополнительный номер): /dev/nvidia0

debug2: gpu/nvml: _get_system_gpu_list_nvml: Диапазон соответствия ЦП — машина: 0-5

debug2: gpu/nvml: _get_system_gpu_list_nvml: Core Affinity Range — Abstract: 0–5

36.06

отладка: gpu/nvml: _get_system_gpu_list_nvml: Версия библиотеки NVML: 11.450.36.06

debug2: gpu/nvml: _get_system_gpu_list_nvml: Общее количество процессоров: 6

debug2: gpu/nvml: _get_system_gpu_list_nvml: Количество устройств: 1

debug2: gpu/nvml: _get_system_gpu_list_nvml: индекс графического процессора 0:

debug2: gpu/nvml: _get_system_gpu_list_nvml: Имя: geforce_rtx_2060

debug2: gpu/nvml: _get_system_gpu_list_nvml: UUID: GPU-g44ef22a-d954-c552-b5c4-7371354534b2

debug2: gpu/nvml: _get_system_gpu_list_nvml: домен PCI/шина/устройство: 0:1:0

debug2: gpu/nvml: _get_system_gpu_list_nvml: идентификатор шины PCI: 00000000:01:00.0

debug2: gpu/nvml: _get_system_gpu_list_nvml: NVLinks: -1

debug2: gpu/nvml: _get_system_gpu_list_nvml: файл устройства (дополнительный номер): /dev/nvidia0

debug2: gpu/nvml: _get_system_gpu_list_nvml: Диапазон соответствия ЦП — машина: 0-5

debug2: gpu/nvml: _get_system_gpu_list_nvml: Core Affinity Range — Abstract: 0–5

Имя=количество миль в секунду=400

Имя=количество миль в секунду=400